今週までにやったこと:

UI:

・ポーズ説明選択画面実装、ポーズ学習選択画面実装

・ポーズ学習画面でポーズをチェックボックスで選択した後、まとめて学習する方式に変更した

ポーズ判定:

・担当するポーズの分担

・画像からもカメラからでもランドマーク座標を取得できるようにした

・ポーズごとの特徴を挙げ、必要そうなランドマークを決めた

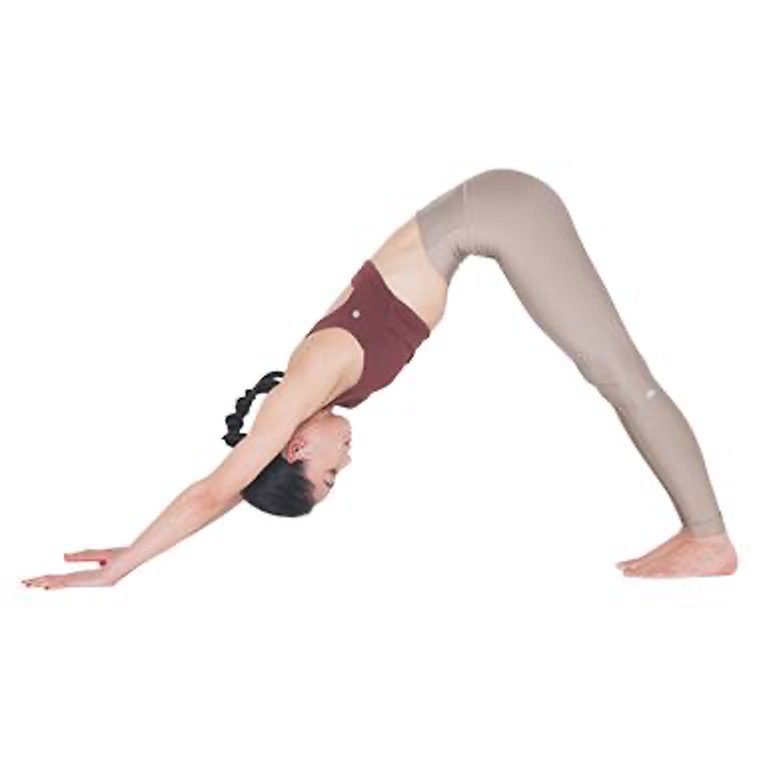

まず、手を合わせているかどうかの判定を行いたかったため、右手左手にあるそれぞれのランドマークを持ってきてそれを使い距離を求めて、その距離が閾値以下だったらOKか駄目かのような形で行おうと思い、画像を使ってまず距離を求めてみました。下の画像を上から①、②、③とし、fullとheavyのモデルの両方で試してみました。

モデルがpose_landmarker_full.taskの場合

モデルがpose_landmarker_heavy.taskの場合

他のものでもやって、heavyの方が精度が良かったのでこれでやろうと思ったのですが、次のポーズだけfullの方が精度が良くなりました。

このような結果になったのでもう少し検討が必要だと思いました。

来週までにやりたいこと:

引き続きUIと判定プログラム作成